#Microsoft Fabric

Text

Database transformations in Microsoft Fabric data pipelines

Database transformations are one of the most common ETL tasks in data warehousing. In this tutorial, I explain how to call database stored procedures, send parameters and read their output in #microsoftfabric data pipelines. Check out here: https://youtu.be/p4VBC_n8Qx4

0 notes

Text

[Fabric] Protegé credenciales en Notebooks con Azure KeyVault

Ciertamente, cuando usamos notebooks, no todo es transformación y limpieza del contenido de nuestro lakehouse. En distintas oportunidades se nos presenta la opción de utilizarlos para integrar datos. Los Notebooks nos pueden ayudar a conectarnos a APIs en nube u otros entornos cloud directamente usando código.

Para que esta opción sea viable, necesitamos evitar exponer las credenciales o claves del origen de datos usadas en el código. Sino imaginen que cualquier persona con acceso al código (ya sea en Fabric o en el repositorio), podría obtener una key de acceso a una API. Para evitar esto, vamos a utilizar un servicio de Azure que ya existe hace tiempo, Azure KeyVaults.

¿Qué es el servicio de Azure Key Vaults?

En palabras Microsoft "Azure Key Vault es un servicio en la nube para el almacenamiento de los secretos y el acceso a estos de forma segura. Un secreto es todo aquello cuyo acceso desea controlar de forma estricta, como las claves API, las contraseñas, los certificados o las claves criptográficas."

Si bien el servicio varias operaciones, nosotros nos quedaremos con la idea que nos permite ingresar una clave o contraseña a encapsular. Solo usuarios con permiso de lectura de claves al servicio podrá utilizar el encapsulado. De ese modo garantizamos que únicamente usuarios aprobados para usarlo, lo usen.

Veamos como crear este secreto antes de usarlo en un Fabric Notebook.

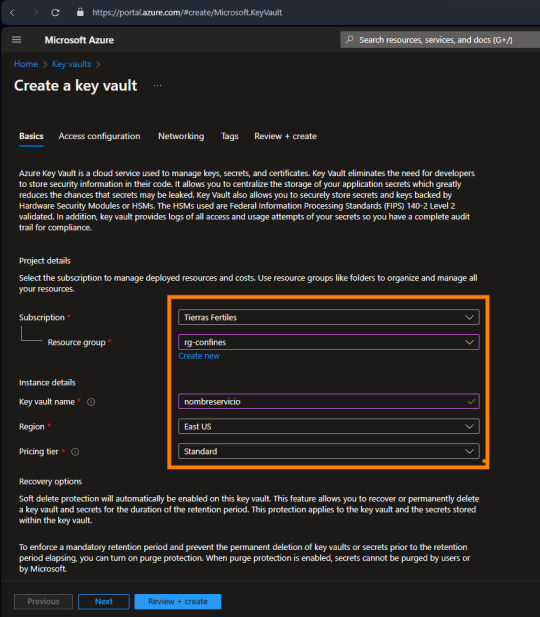

La creación del servicio es bastante simple, basta seleccionar suscripción + grupo de recursos, nombre, region y plan:

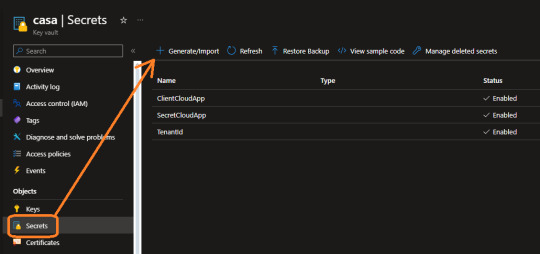

Como mencioné antes, el servicio cuenta con muchas más cosas de las que usaremos nosotros. Ahora nos vamos a concentrar en "Secretos" que es lo que nos interesa.

Aqui por ejemplo ya contamos con tres secretos que usaremos para conectar a la PowerBi Rest API. Guardamos secreto para el tenantid, appid y secretvalue de nuestra app registrada en Azure.

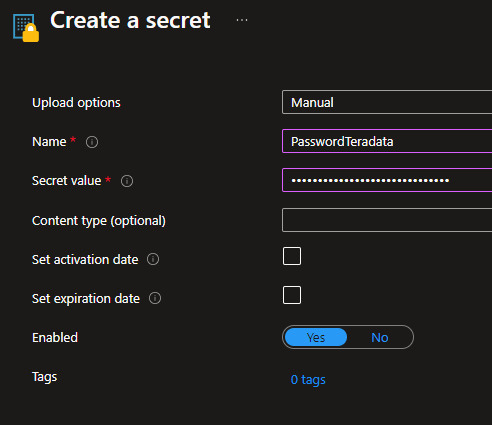

Veamos como generar uno nuevo. Es tan simple como darle un nombre y delimitar lo que queremos encapsular. También podemos delimitarlo como algo temporal:

De ese modo podemos crear un nuevo secreto para nuestro almacén de claves. ¿Qué sigue? permitir la lectura a quien vaya a utilizarlo.

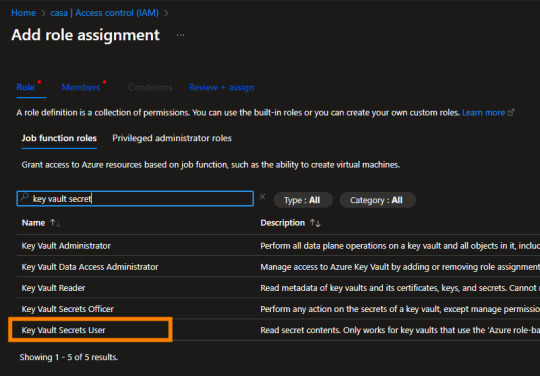

Los recursos de azure se manejan con permisos RBAC (role-based access control). Éstos los encontramos en el "Access Control (IAM)". Podemos abrir nuestro menú de permisos y agregar el que lleva el nombre de "Key Vault Secrets User". La cuenta de EntraID con ese permiso, podrá llamar por código a nuestro secreto almacenado aquí.

Este proceso es muy importante. Imaginen que con esto podríamos dar permisos a un desarrollador para construir un proceso sin saber nunca las credenciales de origen.

¿Cómo llamarlo desde Fabric?

Para utilizar este servicio desde Fabric Notebook usando python, vamos a nutrirnos de la librería de Microsoft que tiene muchas facilidades de interacción. Pueden leer más detalles aqui: https://learn.microsoft.com/en-us/fabric/data-engineering/microsoft-spark-utilities

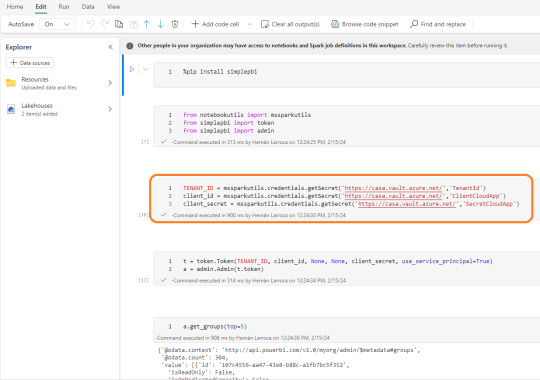

Dentro de nuestro notebook vamos a comenzar importando SimplePBI para conectarme a la Power Bi Rest API. Luego importaremos las librerías necesarias. El foco está en nuestra tercera celda. Aqui podremos apreciar como llamar el secreto almacenado recientemente:

Utilizamos el método getSecret que necesita dos parámetros. El primero es "Vault URI" que podemos encontrarlo en el Overview de nuestro recurso en el portal de Azure. El segundo es el nombre que le dimos a nuestro secreto.

mssparkutils.credentials.getSecret('https://casa.vault.azure.net/','TenantId')

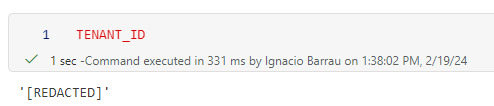

De ese modo almacenamos en variables nuestro resultado y podemos continuar la autenticación de la API en las siguientes filas que crea un token y pide ver el top 5 de workspaces. Recordemos que aquí buscamos seguridad, no solo de exposición de contraseña en código sino de visualización del contenido del secreto. Si el desarrollador intenta leer la variable se encontrará con una limitante:

NOTA: ésta tercera celda pidiendo el secreto solo puede ser ejecutada por una cuenta logueada en Fabric con permisos "Key Vault Secrets User" en nuestro Key Vault. Sino fallará por prohibición de acceso al secreto.

Espero que esto les sea de utilidad para poner automatizar flujos de manera más segura usando Fabric Notebooks.

#Azure#Azure keyvaults#Fabric#Microsoft fabric#Fabric argentina#fabric cordoba#Fabric jujuy#Fabric tutorial#fabric training#Fabric tips#SimplePBI#Fabric python#Fabric notebooks

0 notes

Text

Microsoft Fabric: Pioneering the AI and Machine Learning Frontier

🌟 Explore Microsoft Fabric: Revolutionizing Data Science & Machine Learning! From data analysis to model training, uncover insights & drive innovation. Read now! #DataScience #MachineLearning #MicrosoftFabric #AI #Innovation #Tech

In today’s dynamic business landscape, organizations are increasingly turning to data science and machine learning to gain insights, make informed decisions, and drive innovation. Imagine you’re working for a supermarket chain. You want to optimize your inventory management to meet customer demands efficiently while minimizing food waste. Or perhaps you aim to personalize your marketing…

View On WordPress

#AI Models#Data Analysis#Data Science#Data Visualization#Data Wrangling#Experiment Tracking#Linear Regression#Logistic Regression#machine learning#microsoft azure#Microsoft Fabric#MLflow#Model Training#Python Programming#scikit-learn

0 notes

Text

Microsoft Introduces specialized AI chips and enhances the copilot experience at the Ignite 2023 event.

New Post has been published on https://majornewshub.com/microsoft-introduces-specialized-ai-chips-and-enhances-the-copilot-experience-at-the-ignite-2023-event/

Microsoft Introduces specialized AI chips and enhances the copilot experience at the Ignite 2023 event.

Microsoft Ignite 2023 की सबसे बड़ी घोषणाएँ: विशेषज्ञ AI चिप्स, विस्तारित कोपायलट अनुभव, और।

फोटो : माइक्रोसॉफ़्ट

कस्टम सिलिकॉन चिप्स

The first two custom silicon chips designed by Microsoft for its cloud infrastructure.

माइक्रोसॉफ्ट ने Azure Maia 100 और Cobalt 100 चिप्स को पेश किया है, जो कंपनी के अपने क्लाउड इंफ्रास्ट्रक्चर के लिए विशेष रूप से तैयार किए गए कस्टम सिलिकॉन चिप्स की शुरुआत है।

फोटो : माइक्रोसॉफ़्ट

माइक्रोसॉफ्ट ने एक अपने आत्मनिर्भर ए.आई. चिप्स का परिचय किया है: Azure Maia 100 ए.आई. एक्सेलरेटर और Azure Cobalt 100 सीपीयू।

Maia 100 का उपयोग ए.आई. मॉडल्स को प्रशिक्षित और चलाने के लिए किया जा सकता है, जबकि Cobalt 100 को सामान्य उद्देश्य के व्यापक लोड चलाने के लिए डिज़ाइन किया गया है |

एज़ूर Maia AI त्वरक चिप है जिसे विशेष रूप से बड़े भाषा मॉडल जैसे OpenAI के GPT-3 को प्रशिक्षित करने और चलाने के लिए डिज़ाइन किया गया है|

और

एज़ूर कोबाल्ट, एक क्लाउड-नेटिव चिप है जो सामान्य प्रयोजन के क्लाउड वर्कलोड के लिए अनुकूलित है।

Microsoft कहता है कि Maia 100 और Cobalt 100 दोनों आगे आने वाले साल से पहले Azure डेटा सेंटर्स में रोल आउट होंगे. ये चिप्स अगले साल की शुरुआत में Azure डेटा केंद्रों में तैनात किए जाएंगे। माइक्रोसॉफ्ट का कहना है कि ये नए चिप्स उसके क्लाउड सेवाओं को और अधिक प्रतिस्पर्धी बना देंगे और ग्राहकों को बेहतर प्रदर्शन और मूल्य प्रदान करेंगे।

2023 का सबसे अवलोकनीय उपकरण Microsoft 365 Copilot

फोटो : ट्विटर

Bing Chat is now Copilot and works on Microsoft Edge, Google Chrome, Safari and soon on mobile. #MSIgnite

Bing Chat अब Copilot है और यह Microsoft Edge, Google Chrome, Safari पर काम करता है और जल्द ही मोबाइल पर भी काम करेगा। #MSIgnite

Bing Chat is now Copilot and works on Microsoft Edge, Google Chrome, Safari and soon on mobile. #MSIgnite pic.twitter.com/m4P3YzdWxL

— Microsoft (@Microsoft) November 15, 2023

Video credit https://x.com/Microsoft?s=20

माइक्रोसॉफ्ट अपने नए कोपायलट उपकरण को सभी के लिए सुलभ और उपयोग में आसान बनाने के लिए कड़ी मेहनत कर रहा है। यह बिंग के साथ शुरू होता है, जहां बिंग चैट और बिंग चैट एंटरप्राइज को अब बस कोपायलट कहा जाएगा। Microsoft Entra ग्राहकों के लिए, कोपायलट Bing, Edge और Windows में अतिरिक्त एंटरप्राइज़-ग्रेड डेटा सुरक्षा प्रदान करता है।

1 दिसंबर, 2023 को, कोपायलट का पूर्वावलोकन समाप्त हो जाएगा और यह आम तौर पर उपलब्ध होगा। Microsoft एंटरप्राइज़-ग्रेड डेटा सुरक्षा के साथ कोपायलट के लिए पात्रता का विस्तार बिना किसी अतिरिक्त लागत के एंट्रा आईडी (पूर्व में Azure Active Directory) के और भी अधिक उपयोगकर्ताओं के लिए कर रहा है।

कोपायलट कई तरह के कार्यों में आपकी सहायता कर सकता है, जिनमें शामिल हैं:

तालिकाओं और चार्ट बनाना

कॉपीलॉट आपको डेटा के आधार पर स्वचालित रूप से चार्ट और तालिकाएँ बनाने में मदद कर सकता है।

प्रम्प्ट के आधार पर डेटा पर उचित सूत्र/हिसाब लागू करें

डेटा को प्रस्तुत करने के लिए चार्ट/ग्राफ की तरह दृश्यीकरण बनाएं

डेटा विश्लेषण से रुझान और अनुशासन संक्षेपित करें

कल्पनात्मक विश्लेषण के माध्यम से विभिन्न परिस्थितियों का अन्वेषण करें

पॉवरपॉइंट स्लाइड बनाना

कॉपीलॉट आपको अपनी प्रस्तुतियों के लिए स्वचालित रूप से स्लाइड बनाने में मदद कर सकता है।

वर्ड दस्तावेज़ को पॉवरपॉइंट प्रस्तुतियों में बदलें

वर्ड दस्तावेज़ को पॉवरपॉइंट प्रस्तुतियों में बदलें

पॉवरपॉइंट में स्लाइड पाठ, स्वरूप, एनीमेशन, और लेआउट को सुधारने के लिए प्राकृतिक भाषा का उपयोग करें

लंबी प्रस्तुतियों को मुख्य स्लाइड्स में संक्षेपित करें

दस्तावेज बनाना

कॉपीलॉट आपको अपने विचारों को स्पष्ट रूप से व्यक्त करने में मदद करने के लिए स्वचालित रूप रूप से वाक्य और अनुच्छेद लिखने में मदद कर सकता है।

साधे प्रॉम्प्ट्स के आधार पर Word दस्तावेज़ उत्पन्न करें

लंबे Word दस्तावेज़ को संक्षेपित करें, मुख्य जानकारी निकालें

पाठ के खंड या पूरे दस्तावेज़ को संक्षेपित या किसी निर्दिष्ट भाव के साथ मेल करने के लिए संशोधित करें

दस्तावेज़ में की गई सबसे महत्वपूर्ण संशोधनों और परिवर्तनों का संक्षेप प्रदान करें

ईमेल लिखना

कॉपीलॉट आपको स्पष्ट, संक्षिप्त और व्यावसायिक ईमेल लिखने में मदद कर सकता है।

कोड लिखना

Azure के लिए Microsoft Copilot IT के लिए एक AI साथी है जो दिन-प्रतिदिन के IT प्रबंधन को सरल बनाता है। सिर्फ एक उपकरण होने के बजाय, Azure के लिए Copilot एक एकीकृत चैट अनुभव प्रदान करता है जो अपने उपयोगकर्ताओं की भूमिकाओं और लक्ष्यों को समझता है, ऐप्स और बुनियादी ढांचे के घटकों को डिजाइन, संचालित और बनाए रखने की उनकी क्षमता को बढ़ाता है। Azure के लिए Copilot IT टीमों को अपने कार्यभार में नई अंतर्दृष्टि प्राप्त करने, पहले से अप्रयुक्त Azure क्षमताओं को अनलॉक करने और क्लाउड और किनारे दोनों पर संचालन को नियंत्रित करने में मदद करता है।

अनुवाद करना

कॉपीलॉट आपको दस्तावेजों और पाठ का अनुवाद करने में मदद कर सकता है।

कॉपीलॉट का उपयोग करने के लिए, बस अपने एप्लिकेशन में कॉपीलॉट बटन पर क्लिक करें और फिर वह कार्य चुनें जो आप करना चाहते हैं। कॉपीलॉट स्वचालित रूप से आपकी सहायता करना शुरू कर देगा।

कॉपीलॉट अभी भी विकास के अधीन है, लेकिन यह पहले से ही एक शक्तिशाली उपकरण है जो आपको अधिक कुशलता से काम करने में मदद कर सकता है।

1. PowerPoint

• Convert Word docs into PowerPoint presentations

• Create new slides in an existing presentation based on prompts

• Use natural language to refine slide text, formatting, animations, and layout

• Summarize lengthy presentations into key slides pic.twitter.com/QGBZvgqCsw

— Bryan Marley (@_bryanmarley) November 16, 2023

कॉपीलॉट को आज़माने के लिए, आज ही माइक्रोसॉफ्ट वेबसाइट पर जाएँ।

Official Website Microsoft – Cloud, Computers, Apps & Gaming

Read More

#Azure AI सामग्री सुरक्षा#Azure AI स्टूडियो#Microsoft 365#Microsoft Copilot#Microsoft Fabric#Microsoft Ignite#आर्टिफिशियल इंटेलिजेंस

0 notes

Text

Unlock the power of AI and revolutionize your data management with Microsoft Fabric. Our Microsoft Fabric Consulting Services bring together AI and all your data sources and analytics services, empowering you to reshape how you access, manage, and act on data and insights.

0 notes

Text

Microsoft, a pioneering tech giant, has been at the forefront of this transformation, consistently pushing the boundaries of what’s possible. One such innovation is Microsoft Fabric, a cutting-edge platform that harnesses the power of AI-enabled next-generation data analytics.

https://qrsolutions.in/microsoft-fabric-unleashing-the-potential-of-ai-enhanced-next-gen-data-analytics/

#Microsoft Fabric#AI-enhanced data analytics#Next-gen data analytics#Unleashing potential#Artificial Intelligence#Predictive analytics#Advanced analytics#Intelligent insights#Scalable infrastructure#Natural language processing#Business intelligence#Cognitive services#Smart data processing#Advanced machine learning

0 notes

Text

Built on the foundation of Microsoft’s extensive experience and expertise in data and AI, Fabric aims to streamline the entire data ecosystem. It provides a comprehensive set of tools, services, and frameworks that enable organizations to effectively manage, process, and derive insights from their data.

On May 23rd, Microsoft unveiled Microsoft Fabric, a unified analytics platform that integrates technologies like Azure Data Factory, Azure Synapse Analytics, and Power BI into a single platform.

0 notes

Text

Was ist Microsoft Fabric?

In dem folgenden YouTube-Video wird Microsoft Fabric vorgestellt, eine neue Software-Service-Lösung von Microsoft. Es handelt sich um eine All-in-One-Lösung für Unternehmen, die verschiedene Dienste und Funktionen integriert. Die Lösung umfasst Dienste wie Power BI, Data Engineering, Data Science und Data Warehousing. Die Grundlage dafür bildet der Data Lake namens “One Lake”. Die Plattform…

View On WordPress

#Data Analysis#Data Engineering#Data Lake#Data Science#Data Warehouse#Fabric#Microsoft Fabric#One Lake#Power BI

0 notes

Text

Building real-time streaming pipelines on Microsoft fabric Lakehouses

How to build real-time pipelines to replicate your ever-changing Lakehouse tables? Although the standard tooling included with #MicrosoftFabric does not allow building streaming applications reading from #Lakehouse tables, you can use the power of Change Data Feed and #Spark Structured Streaming to build low-latency pipelines to replicate your data and transformations to Lakehouse destinations. Check out my video on this: https://youtu.be/LeWOG_4umb8

0 notes

Text

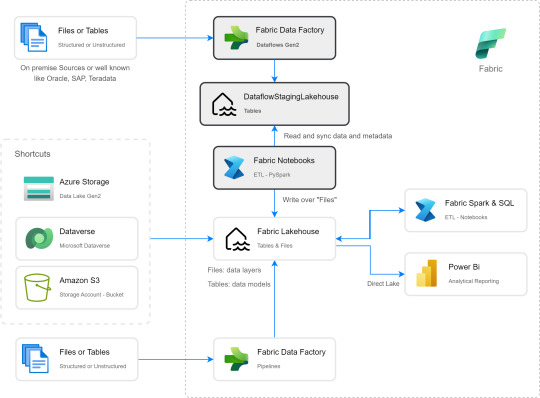

[Fabric] Dataflows Gen2 destino “archivos” - Opción 2

Continuamos con la problematica de una estructura lakehouse del estilo “medallón” (bronze, silver, gold) con Fabric, en la cual, la herramienta de integración de datos de mayor conectividad, Dataflow gen2, no permite la inserción en este apartado de nuestro sistema de archivos, sino que su destino es un spark catalog. ¿Cómo podemos utilizar la herramienta para armar un flujo limpio que tenga nuestros datos crudos en bronze?

Veamos una opción más pythonesca donde podamos realizar la integración de datos mediante dos contenidos de Fabric

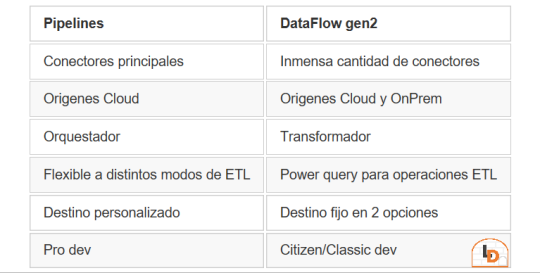

Como repaso de la problemática, veamos un poco la comparativa de las características de las herramientas de integración de Data Factory dentro de Fabric (Feb 2024)

Si nuestro origen solo puede ser leído con Dataflows Gen2 y queremos iniciar nuestro proceso de datos en Raw o Bronze de Archivos de un Lakehouse, no podríamos dado el impedimento de delimitar el destino en la herramienta.

Para solucionarlo planteamos un punto medio de stage y un shortcut en un post anterior. Pueden leerlo para tener más cercanía y contexto con esa alternativa.

Ahora vamos a verlo de otro modo. El planteo bajo el cual llegamos a esta solución fue conociendo en más profundidad la herramienta. Conociendo que Dataflows Gen2 tiene la característica de generar por si mismo un StagingLakehouse, ¿por qué no usarlo?. Si no sabes de que hablo, podes leer todo sobre staging de lakehouse en este post.

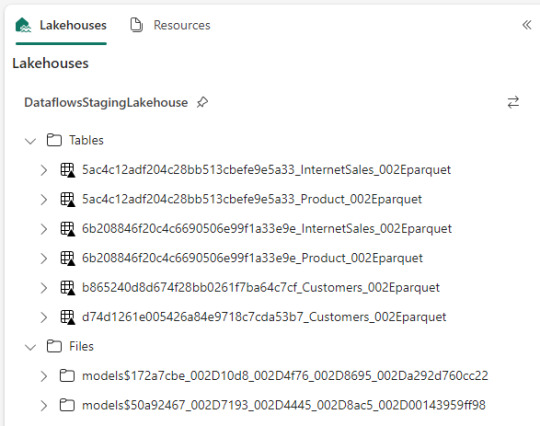

Ejemplo práctico. Cree dos dataflows que lean datos con "Enable Staging" activado pero sin destino. Un dataflow tiene dos tablas (InternetSales y Producto) y otro tiene una tabla (Product). De esa forma pensaba aprovechar este stage automático sin necesidad de crear uno. Sin embargo, al conectarme me encontre con lo siguiente:

Dataflow gen2 por defecto genera snapshots de cada actualización. Los dataflows corrieron dos veces entonces hay 6 tablas. Por si fuera aún más dificil, ocurre que las tablas no tienen metadata. Sus columnas están expresadas como "column1, column2, column3,...".

Si prestamos atención en "Files" tenemos dos models. Cada uno de ellos son jsons con toda la información de cada dataflow.

Muy buena información pero de shortcut difícilmente podríamos solucionarlo. Sin perder la curiosidad hablo con un Data Engineer para preguntarle más en detalle sobre la información que podemos encontrar de Tablas Delta, puesto que Fabric almacena Delta por defecto en "Tables". Ahi me compartió que podemos ver la última fecha de modificación con lo que podríamos conocer cual de esos snapshots es el más reciente para moverlo a Bronze o Raw con un Notebook. El desafío estaba. Leer la tabla delta más reciente, leer su metadata en los json de files y armar un spark dataframe para llevarlo a Bronze de nuestro lakehouse. Algo así:

Si apreciamos las cajas con fondo gris, podremos ver el proceso. Primero tomar los datos con Dataflow Gen2 sin configurar destino asegurando tener "Enable Staging" activado. De esa forma llevamos los datos al punto intermedio. Luego construir un Notebook para leerlo, en mi caso el código está preparado para construir un Bronze de todas las tablas de un dataflow, es decir que sería un Notebook por cada Dataflow.

¿Qué encontraremos en el notebook?

Para no ir celda tras celda pegando imágenes, puede abrirlo de mi GitHub y seguir los pasos con el siguiente texto.

Trás importar las librerías haremos los siguientes pasos para conseguir nuestro objetivo.

1- Delimitar parámetros de Onelake origen y Onelake destino. Definir Dataflow a procesar.

Podemos tomar la dirección de los lake viendo las propiedades de carpetas cuando lo exploramos:

La dirección del dataflow esta delimitado en los archivos jsons dentro de la sección Files del StagingLakehouse. El parámetro sería más o menos así:

Files/models$50a92467_002D7193_002D4445_002D8ac5_002D00143959ff98/*.json

2- Armar una lista con nombre de los snapshots de tablas en Tables

3- Construimos una nueva lista con cada Tabla y su última fecha de modificación para conocer cual de los snapshots es el más reciente.

4- Creamos un pandas dataframe que tenga nombre de la tabla delta, el nombre semántico apropiado y la fecha de modificación

5- Buscamos la metadata (nombre de columnas) de cada Tabla puesto que, tal como mencioné antes, en sus logs delta no se encuentran.

6- Recorremos los nombre apropiados de tabla buscando su más reciente fecha para extraer el apropiado nombre del StagingLakehouse con su apropiada metadata y lo escribimos en destino.

Para más detalle cada línea de código esta documentada.

De esta forma llegaríamos a construir la arquitectura planteada arriba. Logramos así construir una integración de datos que nos permita conectarnos a orígenes SAP, Oracle, Teradata u otro onpremise que son clásicos y hoy Pipelines no puede, para continuar el flujo de llevarlos a Bronze/Raw de nuestra arquitectura medallón en un solo tramo. Dejamos así una arquitectura y paso del dato más limpio.

Por supuesto, esta solución tiene mucho potencial de mejora como por ejemplo no tener un notebook por dataflow, sino integrar de algún modo aún más la solución.

#dataflow#data integration#fabric#microsoft fabric#fabric tutorial#fabric tips#fabric training#data engineering#notebooks#python#pyspark#pandas

0 notes

Text

Unlock Data Governance: Revolutionary Table-Level Access in Modern Platforms

Dive into our latest blog on mastering data governance with Microsoft Fabric & Databricks. Discover key strategies for robust table-level access control and secure your enterprise's data. A must-read for IT pros! #DataGovernance #Security

View On WordPress

#Access Control#Azure Databricks#Big data analytics#Cloud Data Services#Data Access Patterns#Data Compliance#Data Governance#Data Lake Storage#Data Management Best Practices#Data Privacy#Data Security#Enterprise Data Management#Lakehouse Architecture#Microsoft Fabric#pyspark#Role-Based Access Control#Sensitive Data Protection#SQL Data Access#Table-Level Security

0 notes

Text

Microsoft Fabric – A one-stop-shop data analytics platform

Microsoft unveiled a unified analytics platform called Microsoft Fabric at the Build 2023 event. However, Fabric is not a brand-new product but a repackaging of Microsoft’s best-of-breed data and analytics tools. Why would Microsoft do that? How will Fabric make a difference for businesses?

Originally published at https://saxon.ai on May 26, 2023.

0 notes

Text

They* are making me reinvent the wheel**

* me

** HID USB footpedal controller software that maps pedal presses to specific keypresses

#this is a stupid fucking problem to have in 2023#we need to kill microsoft and apple and google and maybe also the fabric store down the street

5 notes

·

View notes

Text

If your enterprise relies on the Microsoft stack, particularly Power BI, and is in the process of shaping its AI and data strategy, Microsoft Fabric deserves your attention.

By offering an integrated platform for data engineering, data warehousing, Power BI, and data science, it holds the potential to simplify operations, enhance decision-making, and drive innovation.

MS still has some work to do to enable a better last mile adoption, and simplify the stack further, but we can assume that MS is treating that with high priority too.

In summary, the promise that the Microsoft Fabric architecture holds for streamlining data operations and enabling holistic insights makes it a strong candidate for businesses seeking efficiency and growth in the data-driven era.

0 notes